Les VPNs et les protocoles SLIP, PPP, PPTP, L2F, L2TP, LCP, IPSec,

MPLS, NAT

Philippe Roudel, Alain Maroc ENIC - TTV02

Sommaire

|

|

-

Autres protocôles impactés par les VPNs

-

Matrice de Compatibilité des protocoles VPN

- FAQ

: Foire Aux Questions

- Q1:

Qu'est-ce que la liste de distribution mail VPN? et

comment y souscrire?

- Q2:

Qu'est-ce qu'un Réseau Privé Virtuel

(VPN:Virtual Private Network)?

- Q3:

Quels sont les types de VPN? et quels sont leurs avantages

et désavantages respectifs?

- Q4:

Qu'est-ce que PPTP? Est-ce une solution viable dans

le cadre d'un VPN?

- Q5:

Qu'est-ce que IPsec? Quelles relations avec les VPN

et les firewalls?

- Q6:

Comment IPSec travaille-t-il avec NAT (Network Address

Translation)?

- Q7:

Comment savoir si un VPN d'accés distant

est la bonne solution pour mon organisation?

- Q8:

Comment puis-je vérifier qui utilise le VPN

pour accéder à mon site?

- Q9:

Comment puis-je vérifier quels types de trafic

réseau sont transmis dans mon VPN?

- Q10:

Dois-je terminé mon VPN sur mon firewall ou

directement sur mon réseau privé?

- Q11:

En quoi l'utilisation du cryptage affecte les performances

des connexions réseaux?

- Q12:

Qu'est-ce que l'authentification forte?

- Q13:

Quelle est l'importance de la longueur de la clé?Qu'est-ce

qu'une attaque "force brute"?

-

Sites Web

- Bibliographie

- Annexes

|

Présentation

Qu’est-ce qu’un VPN ?

Les réseaux privés virtuels (VPN : Virtual Private Network)

permettent à l’utilisateur de créer un chemin virtuel sécurisé

entre

une source et une destination. Avec le développement d’Internet, il

est intéressant de permettre ce processus de transfert de

données sécurisé et fiable. Grâce à un

principe de tunnel (tunnelling) dont chaque extrémité est identifiée,

les données

transitent après avoir été chiffrées.

Un des grands intérêts des VPN est de réaliser des réseaux

privés à moindre coût. En chiffrant les données,

tout se passe

exactement comme si la connexion se faisait en dehors d’Internet. Il faut

par contre tenir compte de la toile, dans le sens

où aucune qualité de service n’est garantie.

Le concept de réseau privé virtuel

Les réseaux locaux d'entreprise (LAN ou RLE) sont des réseaux

internes à une organisation, c'est-à-dire que les liaisons

entre machines appartiennent à l'organisation. Ces réseaux

sont de plus en plus reliés à Internet par l'intermédiaire

d'un

système proxy (faisant souvent office de firewall pour des raisons

de sécurité), c'est-à-dire une machine qui filtre les

données

en provenance et à destination d'Internet afin de constituer un véritable

garde-barrière.

Sur Internet, les liaisons sont beaucoup plus vulnérables car les

données peuvent passer par des lignes susceptibles d'être

"écoutées". Ainsi, étant donné que certaines

entreprises ne peuvent pas se permettre de relier deux réseaux locaux

distants

par une ligne spécialisée, il est parfois nécessaire

d'utiliser Internet comme support de transmission. On parle alors de

réseau privé virtuel (aussi appelé VPN, acronyme de

Virtual Private Network) lorsque les données transitant sur Internet

sont sécurisées (c'est-à-dire cryptées). Ce réseau

est dit virtuel car il relie deux réseaux "physiques" (réseaux

locaux) par

une liaison Internet, et privé car seuls les ordinateurs des réseaux

locaux faisant partie du VPN peuvent accéder aux données.

Les VPNs offrent l'évolutivité en terme de connectivité

d'entreprise, déployé sur une infrastructure partagée

avec les mêmes

critères d'efficacité est appréciable sur un réseau

privé. Ces critères incluent la sécurité, la

gestion des priorités, la fiabilité, et

la gestion bout en bout.

Un VPN peut-être déployé au-travers d'Internet o u construit

sur un réseau IP, frame Relay, ATM d'un fournisseur de service.

Les VPNs basés sur IP peuvent naturellement étendre l'omniprésence

des intranets au-delà d'une zone interconnectée

vers les agences distantes, les utilisateurs mobiles ou les télé

travailleurs. De plus, ils peuvent étendre les extranets vers

des groupement d'intérêt économique en dehors de l'organisation,

relier les partenaires clients et fournisseurs, améliorant

la satisfaction client, permettant de se différencier au niveau marché,

et de réduire les coûts de transformation (manufacturage).

Les trois types de base de VPNs

Les VPNs d'accès sont un besoin des travailleurs mobiles, télé

travailleurs et petites agences.

Ce business est très dynamique, l'institut Forrest Research évalue

à 55% des entreprises qui ont des projets de réalisation

de VPNs en tant qu'extension à leur réseau actuel. Les raisons

évoquées par les petites ou grandes sociétés

sont les

mêmes à savoir le ratio prix/performance avantageux et la flexibilité

offerte par l'offre basé sur IP. Toutes les études de

marchés laissent supposer un très grande croissance de la demande

pour les VPNs d'accès. Un rapport de Data Corporation

International prévoit que le nombre des accès (d'entreprises)

atteindra 85,000 en 2002. Une grande partie de cette croissance

se fera grâce aux segments de marché du sans-fil et de l'accès

DSL Les raisons de cette croissance rapide sont à relier au

phénoménal succès de l'Internet et à l'accroissement

du nombre de télé travailleurs De même que les télé

travailleurs, les utilisateurs

mobiles et les agences "satellite", les fournisseurs de services comme les

partenaires (clients, fournisseurs) commencent à prendre

conscience des avantages des solutions accès VPN. Les nouvelles applications

comme la vidéoconférence, la formation à distance,

et l'édition permettent d'envisager une augmentation de la productivité

et une réduction des coûts. Comme c'est nouvelles applications

sont de plus en plus sophistiquées, les entreprises ont besoin d'utiliser

plus qu'un service de transport de base de la part de leur

fournisseur de service. Elles ont besoin d'un contrôle sécurisé

pour maintenir l'intégrité de leur propre réseau. De

plus, ce service

émergent demandera des applications de management de ressource et

supervision pour optimiser les applications stratégiques

et les flux d'informations.

Comment marche un VPN ?

Un réseau privé virtuel repose sur un protocole, appelé

protocole de tunneling, c'est-à-dire un protocole permettant aux données

passant d'une extrémité du VPN à l'autre d'être

sécurisées par des algorithmes de cryptographie.

De cette façon, lorsqu'un utilisateur du VPN nécessite d'accéder

à des données situées sur un autre réseau local

du réseau privé virtuel,

sa requête va être transmise en clair au système proxy,

qui va se connecter au réseau distant par l'intermédiaire d'une

ligne téléphonique

(analogique, c'est-à-dire par modem ou numérique) puis va transmettre

la requête de façon cryptée. L'ordinateur distant va

alors fournir

les données au système pare-feu de son réseau local

qui va transmettre la réponse de façon cryptées. A réception

sur le proxy de

l'utilisateur, les données seront décryptées, puis transmises

à l'utilisateur...

Le principe du VPN est basé sur la technique du tunnelling. Cela consiste

à construire un chemin virtuel après avoir identifié

l’émetteur

et le destinataire. Ensuite la source chiffre les données et les achemine

en empruntant ce chemin virtuel. Pour assurer un accès

aisé et peu coûteux aux intranets ou aux extranets d'entreprise,

les réseaux privés virtuels d'accès simulent un réseau

privé, alors

qu'ils utilisent en réalité une infrastructure partagée,

comme Internet.

Les données à transmettre peuvent appartenir à un protocole

différent d’IP. Dans ce cas le protocole de tunnelling encapsule les

données en rajoutant une entête. Permettant le routage des trames

dans le tunnel. Le tunneling est l’ensemble des processus

d’encapsulation, de transmission et de désencapsulation.

Un exemple de méthode d’encapsulation : GRE (Generic Routing Encapsulation).

L’encapsulation avec GRE consiste en l’ajout d’un en-tête qui contient

les informations relatives au tunnel.

A quoi sert un

VPN ?

Auparavant pour interconnecter deux LANs distants, il n’y avait que deux

solutions, soit les deux sites distants étaient reliés par

une ligne spécialisée permettant de réaliser un WAN

entre les deux sites soient les deux réseaux communiquaient par le

RTC.

Une des premières applications des VPN est de permettre à un

hôte distant d’accéder à l’intranet de son entreprise

ou à celui d’un

client grâce à Internet tout en garantissant la sécurité

des échanges. Il utilise la connexion avec son fournisseur d’accès

pour se

connecter à Internet et grâce aux VPN, il crée un réseau

privé virtuel entre l’appelant et le serveur de VPN de l’entreprise.

Cette solution est particulièrement intéressante pour des commerciaux

sillonnant la France : ils peuvent se connecter de façon

sécurisée et d’où ils veulent aux ressources de l’entreprise.

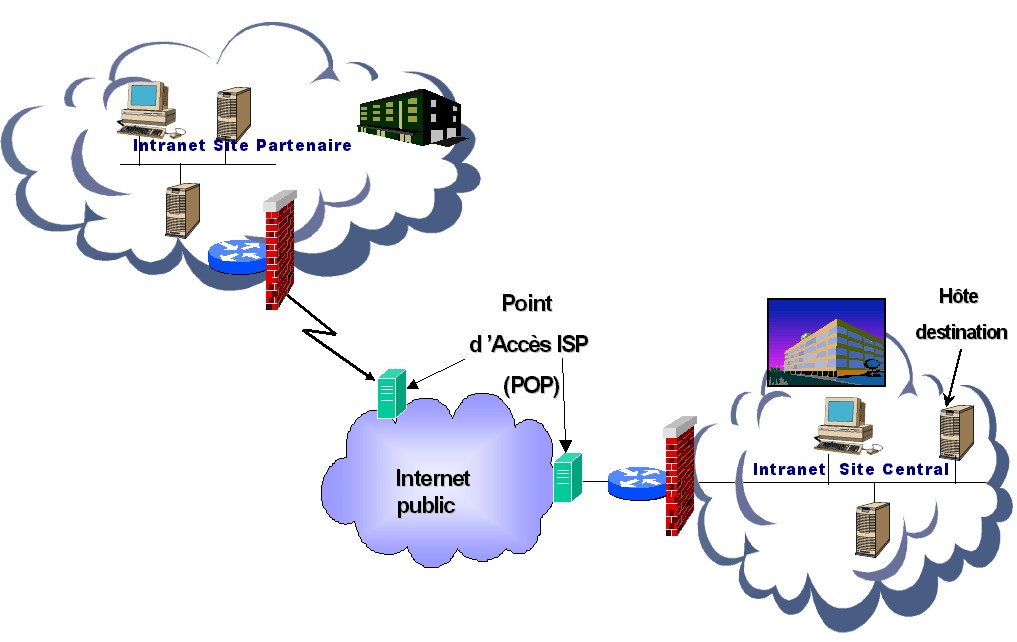

Cela dit, les VPN peuvent également être utilisés à

l’intérieur même de

l’entreprise, sur l’intranet, pour l’échange de données confidentielles.

Services des VPNs

Ces VPN n’ont pas comme seul intérêt l’extension des WAN

à moindre coût mais aussi l’utilisation de services ou fonctions

spécifiques assurant la QoS et la sécurité des échanges.

Les fonctionnalités de sécurité sont matures mais par

contre la

réservation de bandes passantes pour les tunnels est encore un service

en développement limité par le concept même d’Internet.

Qualité de Service

(QoS)

La Qualité de Service (QoS) est un ingrédient essentiel

des VPN, elle est déterminante et permet d'assigner les ressources

réseaux en vue d'applications de type mission critique(mission critical)

ou sensibles en terme de délai de transmission.

Les applications de type haute disponibilité et mission critique (mission

critical) étant fondamentales pour les transactions

commerciales, les rapports de gestion financières, les commandes fabrication,

les demandes de réapprovisionnement

et le suivi de la chaîne logistique.

Celles-ci demandent un niveau de priorité bien supérieure au

surf Web. Les applications sensibles au délai de transmission

comme la formation en ligne ou la vidéoconférence demande une

QoS qui alloue suffisamment de bande passante pour

éviter la gigue (jitter) et par la même un faible niveau de

qualité.

La QoS répond à deux besoins fondamentaux des applications

qui transitent sur les VPN:

-Le niveau de performance est prévisible

-Une politique et des régles peuvent être implémentées.

Les règles sont utilisées pour identifier les applications,

les groupes de projet ou toute autre organisation basée sur des

règles de priorité. L'accroissement du trafic réseau

doit être un compromis tout au long des projets entre l'utilisation

de la bande passante réseau et des règles réseaux

avec les objectifs de l'entreprise. Les équipements peuvent offrir

aujourd'hui la capacité QoS qui permet aux utilisateurs de

gérer la priorité des classes de service, de gérer l'utilisation

de la bande passante, d'éviter la congestion, assure une qualité

de service que ce soit au niveau 2 ou au niveau 3.

La qualité de service (QoS) est une fonctionnalité importante

des VPN n’est pas encore une technologie assez mature et les

solutions proposées sur le marché à l’heure actuelle

ne permettent que des garanties sur des réseaux locaux propriétaires.

C’est pourquoi peu d’ISP proposent à leurs clients des solutions VPN.

La sécurité des échanges est assurée à

plusieurs niveaux et par différentes fonctions comme le cryptage des

données,

l’authentification des deux extrémités communicantes et le

contrôle d’accès des utilisateurs aux ressources.

Sécurité

La sécurité est un point critique pour tous les réseaux.

C'est en fait, la première inquiétude pour l'entreprise qui

envisage d'utiliser la technologie VPN. Avec une planification correcte de

la sécurité en place, l'information acheminée à

travers une

infrastructure partagée peut être sécurisée avec

un niveau de sécurité équivalent à celle d'un

réseau privé.

Ceci est possible grâce aux cryptages des données, à

l'accès restreint aux utilisateurs autorisés et au "traçage"

des

utilisateurs une fois connectés au réseau.

Les VPNs sont construit autour du concept AAA(authentication, authorization,

accounting ) :

-Authentification

-Autorisation

-Gestion de compte (accounting)

Ceci grâce à l'authentification des utilisateurs, du niveau

d'accès, et à la collecte et enregistrement des informations

de connexion.

Un tunnel logique créé une connexion point à point sur

un réseau IP sans connexion. Un tunnel crypté fourni réseau

et données et garantie la confidentialité des informations

transmises grâce à un encodage/brouillage qui ne peut être

décrypté que par l'expéditeur ou le destinataire des

données.

IPSec incorpore une technologie de cryptage éprouvée et sure.

L'encapsulation de protocole sécurisé

( Encapsulating Security Protocol(ESP)) et le cryptage standard de données

( Data Encryption Standard (DES))

sont utilisés par IPSec afin de protéger la charge utile ou

la partie données du paquet.

Les télé travailleurs, commerciaux terrains, agents, agence

distantes, filiale, et autres utilisateurs distants ou mobiles

sont les premiers candidats à l'utilisation des VPN d'accès.

Les VPN d'accès fournissent un accès à l'Intranet ou

l' Extranet à travers une infrastructure partagée avec la même

politique qu'un réseau privé. Cela inclus la connectivité

accès distant via les technologies RTC, ISDN, DSL, du sans-fil et

du câble.

Les VPNs d'accès permettent aux entreprises d'externaliser l'accès

distant sans compromettre leur politique de sécurité.

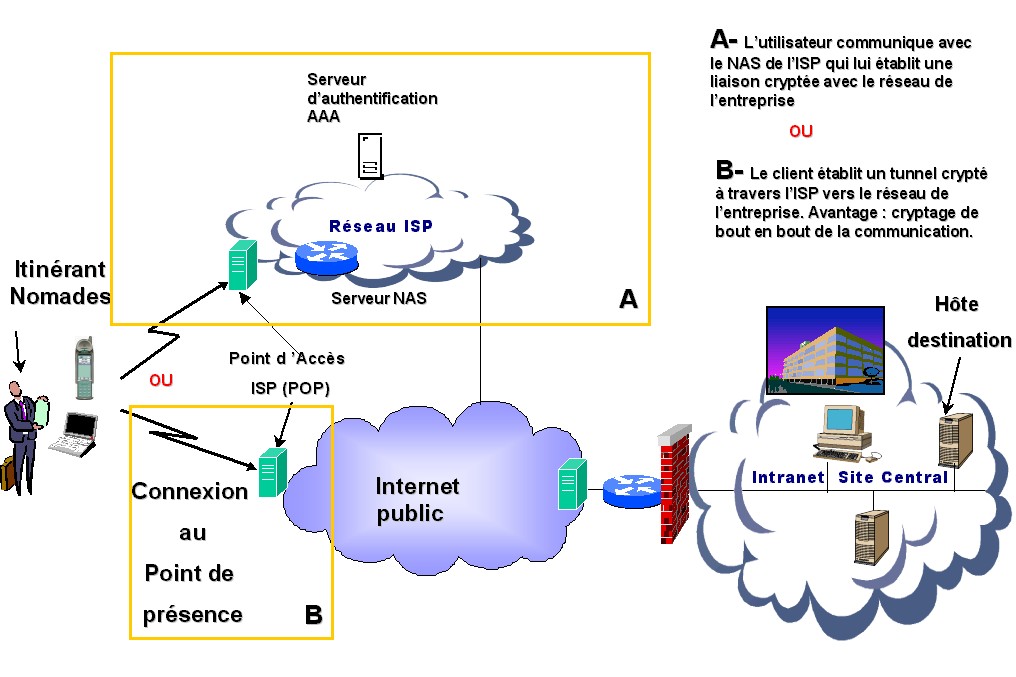

Cela englobe deux options d'architecture:

-la connexion sur l’initiative du client.

-la connexion sur l’initiative du serveur (NAS : Network Access Server ).

Avec le VPN d'accès à base de connexion à l'initiative

client, les utilisateurs établissent un tunnel IP crypté

de leurs clients via un réseau d'ISP (Internet Service Provider) vers

le réseau de l'entreprise. Avec cette architecture,

l'utilisateur distant utilise un logiciel client qui initialise le tunnel.

L'architecture VPN à base de connexion sur l’initiative du client

fournit une sécurité de bout en bout du client au serveur.

Ce qui est idéal pour les applications bancaires ou toutes autres

transactions sensibles à travers le réseau Internet.

L'utilisateur final a en sa possession un logiciel client IPSec installé

sur le site distant, qui peut se terminer avec un vis à vis côté

réseau entreprise du type firewall à base de router ou un firewall

type PIX appliance. Les solutions IPSec VPN, afin d'assurer une solution

sécurisée totalement, peuvent supporter une architecture à

clé publique

(IKE Internet Key Exchange).

L'autre architecture des VPNs d'accès définie des tunnels initialisés

à partir du NAS.Dans ce scénario, les

utilisateurs distants appellent un POP (Provider Point Of Presence) d'un

fournisseur d'accès local ou un numéro

libre accès (numéro vert par exemple), et le fournisseur de

service initialise un tunnel crypté et sécurisé vers

le

réseau de l'entreprise. Avec l'architecture initialisation à

partir du NAS (NAS-initiated) les fournisseurs de services

authentifient l'utilisateur qui accède au réseau de l'entreprise;

toutefois, les entreprises gardent le contrôle de leur

politique de sécurité, définnissent les privilèges

utilisateurs autorisés, et l'information d'où l'utilisateur

à accèdè

au réseau. Cette authentification permet au fournisseur de service

d'authentifier les utilisateurs qui accèdent à ses

NAS, et à l'entreprise d'authentifier à nouveau

les utilisateurs sur son propre router et firewall.

Les premiers avantages du VPN d'accès à initialisation à

partir du NAS sont la gestion de priorité, l'équilibrage de

charge,

et la redondance. Les VPN d'accès à initialisation à

partir du NAS révèlent aux compagnies les détails, implications

et la complexité de la supervision d'un réseau sécurisé,

permettant au fournisseur de services de garder beaucoup

de détails qui ne sont pas le cœur de métier de l'entreprise.

Toutefois quelques applications peuvent nécessités un VPN d'accès

à initialisation à partir du client, quand l'utilisateur

veut être sur que les données sont cryptées depuis la

source jusqu'au serveur distant.

Avec les VPNs à initialisation à partir du NAS, les lignes

RTC standards ou ISDN sont utilisées et la charge utile est

crypté seulement du NAS au routeur/firewall de l'entreprise, où

l'intrusion est la plus probable.

L'accès VPN pour l' entreprise.

Que l'on ait à construire ou faire construire son propre réseau

privé virtuel IP (IP Virtual Private Network VPN), qui offre la sécurité,

la fiabilité et un accès distant économiquement

viable et facilement évolutif pour coller au changement rapide du

secteur

économique de l'entreprise, les responsables réseaux doivent

continuellement trouver un moyen de connecter géographiquement

les groupes de travail, agences dispersées cela de manière

efficace et économique. L'accroissement des demandes dû à

l'enrichissement fonctionnel des applications utilisées largement

par tous les employés dispersés a créé la nécessité

de repenser toutes les stratégies réseaux. Les compagnies étendent

leurs réseaux afin de relier les partenaires, et un nombre de

télé travailleurs et d'utilisateurs distants continuellement

en accroissement, construire une entreprise distribuée relève

de plus

en plus du challenge. Afin de relever ce challenge, les VPNs ont émergés,

permettant aux organisations de sous-traiter les

ressources réseaux en partageant les infrastructures réseaux.

Les Accès VPNs en particulier permettent la mobilité, les

utilisateurs distants peuvent se connecter au réseau d'entreprise,

au moment, comme et d’où ils le souhaitent L'association

avec un fournisseur de service pour construire un accès VPN

peut offrir un service sécurisé, privé et fiable, ce

qui signifie

réduire le coût d'immobilisation. Le fournisseur de service

devient un expert en besoin de communication inter et intra entreprise

permettant à l'entreprise de se recentrer sur son secteur d'activités

principales et son secteur d'expertise principale.

Rappels

SLIP : Serial Line IP

Les familles de protocoles TCP/IP fonctionnent sur une grande variété

de supports : les réseaux locaux IEEE 802.3 (Ethernet)

et 802.5 (Token Ring), les lignes X25, les liaisons satellites et série.

La plupart des transmissions de données se font via des

interfaces séries. Une interface série est juste une interface

qui envoie les données comme une série de bits sur un "seul

fil"

en opposition à une interface parallèle qui envoie cette série

de bits sur "plusieurs fils" simultanément. Cette description d'une

interface série convient pour la plupart des interfaces de communications

(y compris Ethernet), mais ce terme désigne

habituellement une interface qui est liée à une ligne téléphonique

au travers d'un modem.

Dans le monde TCP/IP, les liaisons séries sont utilisées pour

créer des WAN (Réseau longue distance). Malheureusement,

un protocole standard au niveau de la couche physique pour les lignes séries

n'a pas toujours existé concernant cette famille

de protocoles TCP/IP. En raison de cette carence, beaucoup de responsables

informatiques ont choisi une même marque de

routeurs pour leur WAN afin d'assurer la communication au niveau de la couche

physique.

La croissance des réseaux longue distance avec TCP/IP a ensuite suscité

un vif intérêt pour la standardisation des

communications sur liaisons séries afin d'être indépendant

de tout fournisseur. De même, l'arrivée de petits systèmes

abordables fonctionnant avec TCP/IP ainsi que des modems à haute vitesse

ont renforcé cette demande.

Le besoin d'une standardisation pour les communications dans les WAN et celui

d'accès TCP/IP par le RTC, ont abouti à

la création de deux protocoles de transmission sur ligne série

: Serial Line IP (SLIP) et Point-to-Point Protocol ( PPP ).

Introduction

SLIP signifie Serial Line IP (IP sur liaison série). Il s'agit

d'une forme simple d'encapsulation des datagrammes IP sur des

liaisons séries, qui est spécifiée dans la RFC 1055

(A Non Standard for Transmission of IP Datagrams Over Serial Lines).

SLIP définit une séquence de caractères qui encapsulent

des paquets IP sur une ligne série, et rien d'autre. Il ne fournit

pas d'adressage, d'identification de paquets, de détection et de correction

d'erreurs ou un mécanisme de correction.

Comme le protocole fonctionne de manière simple, il est très

facile de le mettre en place. SLIP est devenu populaire

grâce à la connexion de systèmes domestiques à

Internet, au travers du port série RS232 rencontré sur la plupart

des ordinateurs et des modems à grande vitesse.

SLIP puise ses origines au début des années 80 dans l'implémentation

de 3COM UNET TCP/IP.

Aux alentours de 1984, Rick Adams mis en œuvre SLIP pour 4.2 Berkeley Unix

et les stations de travail Sun

Microsystems. Bien qu'ayant été décrit comme non standard,

il devint de plus en plus populaire pour finalement

être considéré comme la voie la plus simple pour connecter

des serveurs TCP/IP et du RTC.

A. Caractéristiques

SLIP est communément utilisé sur des liaisons séries

dédiées et sur des lignes dont la vitesse va de 1200 bits

par seconde et 19.2 KBits par seconde. Les configurations les plus courantes

de connexion sous TCP/IP sont :

Host - Host

Routeur - Routeur

Host - Routeur

Les configurations ci-après décrivent un exemple de connexions

SLIP possibles à un serveur utilisant l'interface V24 (RS232C).

Dans ce diagramme, les PC ont été connectés au serveur

central mais il pourrait s'agir de n'importe quelle machine

pouvant fonctionner avec SLIP et TCP/IP.

Le serveur est ici en liaison avec un réseau local (LAN), et il peut

être utilisé comme un routeur pour se connecter à partir

des PC au LAN pour obtenir d'autres services.

B. Protocole

Le protocole SLIP définit un mécanisme simple de "mise sous

forme de trames" des diagrammes en vue de leur transmission

sur la ligne série sous la forme d'une série d'octets et utilise

des caractères spéciaux pour indiquer qu'une série d'octets

devraient être regroupés pour former un datagramme.

Pour ce faire, SLIP définit deux séquences de caractères

spéciaux :

La séquence de caractères SLIP END occupe un seul octet dont

la valeur décimale est 192 (0xc0). Cette séquence

indique la fin d'un datagramme complet qu'il peut alors transmettre à

IP.

La séquence de caractères SLIP ESC occupe un seul octet dont

la valeur décimale est 219 (0xdb). Cette séquence est

utilisée pour "changer le code" des caractères de contrôle

de SLIP. Si le SLIP émetteur met en évidence une valeur d'octet

équivalente à la valeur de la séquence de caractères

SLIP END ou ESC dans le datagramme qu'il envoie, il convertit cette

séquence de caractères en une séquence constituée

de deux caractères. Les séquences de deux caractères

sont

ESC 220 (0xdc) pour le caractère END et ESC 221 (0xdd) pour le caractère

ESC.

Phil Karn a suggéré d'insérer un caractère

END au début du datagramme IP. Le datagramme IP se termine par le

caractère spécial appelé END (0xc0).

Aussi, pour éviter à tout bruit de ligne avant ce datagramme

d'être interprété comme faisant partie de ce datagramme,

la plupart des implémentations transmettent également un caractère

END en tête du datagramme.

S'il y a du bruit sur la ligne, ce caractère END arrête la transmission

erronée, permettant au datagramme courant d'être

envoyé. Le datagramme erroné sera rejeté par une couche

supérieure lorsque son contenu sera reconnu comme non valide.

Parce qu'il n'y a pas de spécification de standard SLIP, il n'y a

pas de taille maximum de paquet définie pour SLIP. Il est

probablement plus judicieux d'accepter la taille maximum de paquet définie

par le pilote SLIP d'UNIX de Berkeley : 1006 octets

incluant le paquet IP et l'en-tête du protocole de transport (n'incluant

pas les caractères d'encapsulation).

Aussi, n'importe quelle nouvelle version de SLIP devra être préparée

à recevoir un datagramme de 1006 octets et à ne pas en

envoyer plus de 1006 dans un datagramme.

C. Faiblesses

Beaucoup de fonctions ne sont pas fournies avec SLIP, ce qui peut poser

des problèmes aux utilisateurs.

En toute honnêteté, SLIP est un protocole très simple

à mettre en œuvre. Il y a déjà longtemps quand ces problèmes

n'étaient

pas réellement importants.

Les déficiences éventuelles de SLIP, se classent en plusieurs

catégories :

Adressage

Le protocole SLIP ne définit pas les informations de contrôle

de la liaison qui peuvent être utilisées pour contrôler

dynamiquement les caractéristiques d'une connexion. Par conséquent,

les systèmes SLIP doivent adopter certaines

caractéristiques des liaisons. Etant donné cette restriction,

SLIP peut être utilisé uniquement si les deux hôtes se

sont

transmis leur adresse IP respective et si la transmission des datagrammes

IP est en cours.

Identification

du type de protocole

SLIP ne possède pas de champ

type (similaire au champ type de la trame Ethernet). Si une ligne série

est utilisée pour

une connexion SLIP, elle ne peut être utilisée que par un protocole.

Donc si deux machines DEC fonctionnant avec TCP/IP et decnet, on ne peut

avoir la même ligne série partagée par ces

deux protocoles entre les deux machines quand elles utilisent SLIP.

Ceci est donc un problème pour les machines multi-protocoles qui peuvent

supporter plus d'un protocole sur la ligne série.

Détection

et correction d'erreurs

SLIP ne compense pas le bruit détecté sur les lignes téléphoniques

lentes. Le protocole n'assure pas la correction d'erreurs.

Les lignes téléphoniques bruyantes vont endommager un certain

nombre de paquets pendant la transmission. La

retransmission est très coûteuse si la vitesse de la ligne est

basse. Mais la correction et la détection d'erreurs n'est

absolument pas nécessaire au niveau de SLIP.

En effet, IP inclut toujours une somme de contrôles, de même

que l'en-tête TCP et les données TCP. Dans l'en-tête UDP

et les données UDP, ceci est optionnel. Mais parce que la retransmission

de paquets endommagés prend du temps,

il pourrait être utile de fournir une sorte de mécanisme de

simples corrections d'erreurs avec SLIP.

Compression

Le protocole SLIP n'assure pas la compression de données. Si la

ligne est assez lente, la compression de paquets peut

améliorer grandement les performances de transmission.

E. Remarques sur SLIP

Pour nombre d'applications, les faiblesses de SLIP s'avèrent sans

importance. Il se peut que seule la transmission de

datagrammes IP soit intéressante pour l'utilisateur s'il connaît

les adresses des deux hôtes impliqués dans la liaison

(il peut les spécifier manuellement ).

De plus, les modems commercialisés actuellement disposent de leurs

propres algorithmes de compression de données

et de correction d'erreurs. Compte tenu de ces éléments, SLIP

est généralement considéré comme étant

approprié

pour assurer l'interconnexion d'hôtes isolés.

Toutefois, dans un environnement dynamique tel qu'un WAN de grande taille,

les problèmes éventuels inhérents à

l'utilisation de SLIP sont généralement considérés

comme constituant autant de faiblesses majeures. Celui-ci est

dès lors considéré comme étant un protocole inapproprié

pour assurer l'interconnexion des routeurs.

CSLIP : une améliorations de SLIP

Puisque les lignes SLIP sont souvent lentes (19200 bits/sec ou moins),

et fréquemment utilisées pour du trafic interactif

(comme Telnet et Rlogin, les deux utilisant TCP), elles tendent à

être composées de petits paquets TCP échangés

à

travers une ligne SLIP. La transmission d'un octet de données nécessite

un en-tête IP de 20 octets et un en-tête TCP

de 20 octets, soit un overhead de 40 octets.

Pour résoudre ce problème de performance, une nouvelle version

de SLIP, appelée CSLIP (pour Compressed SLIP),

a été spécifiée dans la RFC 1144 (Van Jacobson

1990). CSLIP réduit généralement l'en-tête de

40 octets à 3 ou 5 octets.

Il maintient l'état de plus de 16 connexions TCP à chaque extrémité

de la liaison CSLIP, et tire partie du fait que certains

des champs des deux en-têtes ne changent pas pour une connexion donnée.

En ce qui concerne les champs qui

changent, la plupart des changements se traduisent par de petits accroissements.

Ces en-têtes plus petits procurent

une amélioration importante du temps de réponse des opérations

interactives.

PPP : Point-to-Point Protocol

Introduction

PPP fut développé pour transférer des données

sur des liens synchrones ou asynchrones entre deux points en utilisant

HDLC comme base d’encapsulation et un Frame Check Sequence (FCS) HDLC pour

la détection des erreurs. Cette

liaison permet le full duplex et garantit l’ordre d’arrivée des paquets.

Une fonctionnalité intéressante de ce protocole est le multiplexage

simultané de plusieurs protocoles de niveau 3 du

modèle OSI.

Ce protocole encapsule des paquets IP, IPX et NetBEUI, … dans des trames

PPP, puis transmet ces paquets PPP

encapsulés à travers la liaison point à point. PPP est

donc utilisé entre un client distant et un serveur d’accès

distant.

Le protocole PPP est décrit dans la RFC 1331.

Format de la trame PPP

Fanion : séparateur de trame.

Un seul drapeau est nécessaire entre 2 trames.

Adresse : Le champ adresse correspond à

une adresse HDLC, or PPP ne permet pas un adressage individuel des

stations donc ce champ doit être à 0xFF (toutes les stations),

toute adresse non reconnue fera que la trame sera détruite.

contrôle : Le champ contrôle

doit être à 0x03, ce qui correspond à une trame HDLC

non numérotée. Toute autre

valeur fera que la trame sera détruite.

Protocole : La valeur contenue dans ce champ

doit être impaire, l’octet de poids fort étant pair. Ce champ

identifie

le protocole encapsulé dans le champ informations de la trame. Les

différentes valeurs utilisables sont définies dans

la RFC « assign number » et représentent les différents

protocoles supportés par PPP (OSI,IP,Decnet IV,IPX,…),

les NCP associés ainsi que les LCP.

Informations : De longueur comprise entre

0 et 1500 octets, ce champ contient le datagramme du protocole

supérieur indiqué dans le champ »protocole ». Sa

longueur est détectée par le drapeau de fin de trame, moins

2 octets de contrôle

FCS (Frame Check Sequence) : Ce champ contient

la valeur du checksum de la trame. PPP vérifie le contenu du

FCS lorsqu’il reçoit un paquet. Le contrôle d’erreur appliqué

par PPP est conforme à X25.

Les familles de protocoles TCP/IP fonctionnent sur une grande variété

de supports : les réseaux locaux

IEEE 802.3 (Ethernet) et 802.5 (Token Ring), les lignes X25, les liaisons

satellites et série. La plupart des

transmissions de données se font via des interfaces séries.

Une interface série est juste une interface qui envoie

les données comme une série de bits sur un "seul fil" en opposition

à une interface parallèle qui envoie cette

série de bits sur "plusieurs fils" simultanément. Cette description

d'une interface série convient pour la plupart

des interfaces de communications (y compris Ethernet), mais ce terme désigne

habituellement une interface

qui est liée à une ligne téléphonique au travers

d'un modem.

Dans le monde TCP/IP, les liaisons séries sont utilisées pour

créer des WAN (Réseau longue distance).

Malheureusement, un protocole standard au niveau de la couche physique pour

les lignes séries n'a pas toujours

existé concernant cette famille de protocoles TCP/IP. En raison de

cette carence, beaucoup de responsables

informatiques ont choisi une même marque de routeurs pour leur WAN

afin d'assurer la communication au

niveau de la couche physique.

La croissance des réseaux longue distance avec TCP/IP a ensuite suscité

un vif intérêt pour la standardisation

des communications sur liaisons séries afin d'être indépendant

de tout fournisseur. De même, l'arrivée de petits

systèmes abordables fonctionnant avec TCP/IP ainsi que des modems

à haute vitesse ont appuyé cette demande.

Le besoin d'une standardisation pour les communications dans les WAN et celui

d'accès TCP/IP par le RTC,

ont abouti à la création de deux protocoles de transmission

sur ligne série : Serial Line IP ( SLIP ) et

Point-to-Point Protocol (PPP).

A. Généralités

Bien plus qu’un standard d’encapsulation de datagramme, les liaisons PPP

résolvent certains problèmes des

protocoles réseaux, tel qu’assigner et gérer des adresses (IP,

X.25 et autres..) . Ce qui est particulièrement difficile

à travers un réseau commuté.

Parallèlement, PPP permet l’encapsulation de trames asynchrones et

synchrones orientées bit, de configurer la

liaison série, de tester la qualité de la liaison, de multiplexer

les différentes couches réseau, détecter les

erreurs, et de ‘’ négocier ‘’ les options avec le site distant, tel

que la compression de donnée, la vitesse de transfert...

PPP résout tout cela à travers un protocole de contrôle

de liaison (LCP) et une famille de protocoles de contrôle

de réseaux pour ‘’négocier’’ les paramètres optionnels

de la configuration.

PPP est composé de trois parties principales :

1 - Une méthode pour encapsuler les datagrammes sur la liaison série.

PPP utilise le format de trame HDLC

( Hight Data Level Control ) de l’ISO ( International Standartization Organisation

).

2 - Un protocole de contrôle de liaison (LCP - Link Control Protocol

) pour établir, configurer et tester la

connexion de liaison de données.

3 - Plusieurs protocoles de contrôle de réseaux (NCPs - Network

Control Protocol ) pour établir configurer les

différents protocoles de couche réseau.

PPP est recommandé pour l'utilisation simultanée de plusieurs

protocoles de couche réseau. En effet, sa

structure permet d’utiliser différents NCP simultanément et

donc de multiplexer simultanément différents

protocoles de couche réseau.

B. Les différentes phases d’une connexion PPP.

"Liaison

morte"

Toute liaison commence et finit obligatoirement par cette phase. Lorsqu'un

événement externe indique que la

couche Physique est prête, PPP passe à la phase suivante, établissement

de la liaison.

Par exemple, une liaison retournera à cette phase après la

déconnexion d'un modem.

"Etablissement

de la liaison"

Dans l’optique d’être transportable sur un grand nombre d’environnements,

PPP comprend un protocole de contrôle

de liens LCP (Link Control Protocol) qui est utilisé pour établir,

configurer, tester, et terminer la connexion à travers

l'échange d’options de configuration jusqu'à ce qu'un des hôtes

modifie une des options pendant la phase.

LCP est utilisé pour manipuler les tailles variables des paquets,

en effet selon le protocole d’encapsulation

sélectionné dans le champ protocole, la taille du champ options/données

n’est pas la même. Ces fonctions de test

permettent de détecter un lien bouclé sur lui-même ou

toute autre erreur classique de configuration. De plus,

seules les options qui sont indépendantes de tout type de réseau,

telles que l'élimination du champ Fanion de la

trame PPP, sont configurées par le LCP (voir informations complémentaires

pour LCP).

D’autres fonctionnalités optionnelles comme l’authentification d’identité

des extrémités, et la détermination de l’état

du lien peuvent s’avérer intéressantes.

"Authentification"

Il est possible qu'un hôte doive s'authentifier avant tout envoi

de messages. Celle-ci n'est pas obligatoire, et doit

être demandée dans la phase précédente, établissement

de la liaison.

Elle doit se faire le plus rapidement possible après l'établissement

de la connexion. Le passage à la phase

suivante, Protocole réseau, n'est possible qu'à la fin de l'authentification,

en cas d'échec, passage à la phase

Terminaison de liaison.

"Protocole

réseau"

Une fois les phases précédentes effectuées par PPP,

chaque protocole réseau doit être configuré séparément

par le protocole de contrôle de réseau (NCP) approprié.

En effet, PPP supporte plusieurs protocoles sur la

même liaison de données.

Le transfert de données est alors possible. Tant que la liaison est

"ouverte", les NCPs (voir annexes pour explication)

peuvent ouvrir et fermer des connexions réseau.

"Terminaison

de liaison"

PPP peut clore une liaison à tout moment, ceci peut être

dû à une authentification qui a échoué, une mauvaise

qualité de la ligne...

Le LCP est utilisé pour la fermeture de la connexion à travers

l'échange de paquets de terminaison.

Lorsque la liaison est close, PPP doit alors en informer les NCPs.

Le protocole de contrôle de liaison (LCP)

PPP utilise le LCP pour négocier une importante liste d'options

de configuration dans une large variété d'environnements.

Ainsi, il est possible d'utiliser PPP entre des hôtes que les administrateurs

réseau ont configuré différemment.

LCP négociera automatiquement les options de configuration.

Le protocole de contrôle de liaison de donnée (LCP - Link Control

Protocol) fournit les informations concernant la

liaison série. Il est utilisé pour établir, négocier

les paramètres de configuration, vérifier la qualité

de liaison et

terminer une connexion point à point. LCP a été développé

spécifiquement pour PPP.

LCP fonctionne à travers 4 phases distinctes :

Phase 1

: Etablissement et configuration de la liaison

Avant que les datagrammes de la couche réseau soit échangés,

LCP doit d’abord confirmer l’ouverture de la

connexion par envoi et réception de paquets. Ces paquets sont émis

par chacun des deux sites. Si ces

échanges sont effectués sans aucun problème - réception

de l’acquittement de configuration

(Configure-Ack) - LCP accepte la connexion, sinon celle-ci est refusée.

Il est important de noter que LCP accepte la configuration de la liaison

et non celle de la couche réseau - effectuée par le protocole

NCP. En effet, tous les paramètres indépendants

de la couche réseau sont configurés et testés à

travers LCP. En cas d’erreur ou de mésentente sur les

options, celles-ci prennent une valeur par défaut.

Phase 2

: Détermination de la qualité de la liaison

Cette phase n’est pas obligatoire. Dans cette phase la liaison est testée

afin de déterminer si la qualité

- débit par exemple - est suffisante pour assurer le transport des

datagrammes de la couche réseau

correspondante. LCP peut retarder la transmission des paquets tant que cette

phase n'est pas

complètement terminé.

La procédure pour déterminer la qualité n’est pas spécifiée

et peut varier d’une implémentation

à l’autre, de plus elle dépend des souhaits de l’utilisateur.

Une méthode est d’utiliser les paquets

LCP Echo-Request et Echo-Reply. Cette phase n’étant pas obligatoire,

il est nécessaire de fixer un temps

maximum afin de ne pas bloquer la connexion.

Phase 3

: Négociation de la configuration du protocole de la couche

réseau

Une fois que LCP a terminé les deux phases précédentes,

le protocole de couche réseau est configuré

séparément par le protocole de contrôle de réseau

approprié (NCPs), et peut être interrompu à n’importe

quel moment. Si LCP interrompt la connexion, il informe NCP qui pourra effectuer

des actions appropriées.

Phase 4

: Fin de la liaison

LCP peut interrompre la liaison à n’importe quel moment, sur un

temps de réponse trop élevé, un événement

physique, par exemple ou bien tout simplement par l’utilisateur.

Informations complémentaires sur LCP

Ce protocole de contrôle de liens est chargé de gérer

les options et les liens créés. LCP est utilisé pour

établir,

maintenir, et fermer la liaison physique.

L’en-tête est le suivant :

Code : Définit, sur un octet, le

type de paquet LCP :

1 : Configure request - 2 : Configure Ack - 3 : Configure NAK - 4 : Configure

Reject - 5 : Terminate Request

- 6 : Terminate Ack - 7 : Code Reject - 8 : Protocol Reject - 9 : Echo Request

- 10 : Echo Reply

- 11 : Discard Request - 12 : Link quality report

Identifiant : Ce champ contient une valeur

numérique qui sert à la gestion des requêtes et des réponses.

Longueur : Longueur totale du paquet LCP.

Ce paquet comprend le code, l’identifiant, la longueur et les données.

Données / Options

: Ce champ de taille variable peut contenir une ou plusieurs

configuration d’options. Le format

d’une configuration d’options LCP possède 3 champs : type, longueur

et données.

- Longueur : Longueur de la configuration d’options, c’est à dire

la longueur des trois champs : type, longueur et données.

- Type : Cet octet indique la configuration d’options ou de données

choisie : Paquets de configurations, paquets de fin

de connexion, paquets détruits ou paquets de test.

Format des

paquets

Les paquets LCP sont encapsulés dans le champ information de la

trame PPP ou le champ Protocole de la

trame a pour valeur le type indiquant des datagrammes LCP c’est à

dire la valeur C021.

Il existe trois classes distinctes de paquets LCP :

1. Les paquets de configuration de liaison, utilisées pour établir

la connexion.

2. Les paquets de terminaison de liaison, utilisées pour clore une

connexion.

3. Les paquets de maintenance de liaison, utilisées pour maintenir

et résoudre certains problèmes sur la ligne.

Le champ Code est sur un octet et identifie le type du paquet LCP.

Les différentes valeurs de ce champ :

1 - Configure-Request

2 - Configure-Ack

3 - Configure-Nack

4 - Configure-Reject

5 - Terminate-Request

6 - Terminate-Ack

7 - Code-Reject

8 - Protocol-Reject

9 - Echo-Request

10 - Echo-Reply

11 - Discard-Request

Le champ identifiant est sur un octet. Son rôle est de faciliter la

reconnaissance des réponses associer à la

requête correspondante.

Le champ Longueur est sur deux octets. Son rôle est indiquer la longueur

du paquet LCP correspond en fait à

la longueur du champ information de la trame principale PPP (vu précédemment

) sans les bits de bourrage.

Le champ Data contient les données demandées par les différentes

requêtes. Sa taille peut être nulle. Son format

est déterminé par la valeur du champ Code.

Il contient les différentes Options qui peuvent être négocier

en réponse a certain paquet tel que Configure-Request,

Echo-Request, Terminate-Request ...

Par exemple, avec le paquet Code-Reject (Code ayant la valeur 7), Il contient

le paquet LCP rejeter.

Les paquets de configuration

Ils servent à établir et configurer la liaison PPP. Ils

sont au nombre de quatre : Configure-Request, Configure-Ack,

Configure-Nak, et Configure-Reject.

Pour ouvrir une connexion PPP, un paquet Configure-Request doit être

envoyé. Le champ Data contient une liste

des options de configuration désirées.

Lorsqu'un hôte reçoit le paquet, il doit obligatoirement

émettre une réponse. Si toutes les options sont acceptées,

le récepteur envoie un acquittement, paquet Configure-Ack. Le champ

Data contient alors une copie exacte des

options de configuration demandées.

En revanche, si certaines des options désirées ne sont pas

acceptables, le récepteur envoie un acquittement

négatif, paquet Configure-Nak. Le champ Data contient uniquement les

options inacceptables.

En somme, l'hôte qui reçoit un Configure-Request peut demander

des options supplémentaires quand il envoie

le Configure-Nak.

Les hôtes continuent d'envoyer des Configure-Request et Configure-Nak

jusqu'à ce qu'ils se mettent d'accord

sur les mêmes options.

Si un hôte reçoit un paquet qui contient des options inconnues,

il doit envoyer un Configure-Reject, dont le

champ Data contiendra uniquement les options rejetées.

La différence entre les options des paquets Configure-Nak et Configure-Reject,

c'est que les options rejetées

ne sont pas négociables.

Les options de configuration seront étudiées ultérieurement.

Les paquets de terminaison

Pour négocier la fermeture d'une liaison PPP, il existe deux paquets

:

Terminate-Request, et Terminate-Ack, dont le champ Data est inutilisé.

Dès qu'un hôte reçoit un Terminate-Request, il doit envoyer

un Terminate-Ack.

Des paquets Terminate-Request doivent être transmis tant qu'un des

trois événements suivants ne s'est pas produit :

- l'émetteur reçoit un Terminate-Ack,

- la couche inférieure n'est plus prête pour communiquer,

- l'émetteur a envoyé un certain nombre de Terminate-Request

non acquittés.

3. Les paquets de maintenance

Ils servent à maintenir et résoudre certains problèmes

sur la liaison. Il en existe cinq : Code-Reject, Protocol-Reject,

Echo-Request, Echo-Reply, Discard-Request.

Quand un hôte reçoit un paquet LCP avec une valeur inconnue

dans le champ Code, il doit transmettre

un paquet Code-Reject, dont le champ de données Rejected-Packet contient

une copie du paquet rejeté, mais

uniquement la partie donnée du champ Information de la trame PPP,

pas les entêtes ni le FCS.

De même, un paquet Protocol-Reject est envoyé en réponse

à une valeur inconnue dans le champ Protocol, et inclut

les champs Rejected-Protocol, qui contient la valeur inconnue du protocole,

et Rejected-Information (similaire au

Rejected-Packet du paquet Code-Reject).

Les paquets Echo-Request et Echo-Reply sont utilisés pour surveiller

la liaison de données PPP, dans les deux sens.

Quand un hôte reçoit un Echo-Request, il doit transmettre un

paquet Echo-Reply.

Le paquet Discard-Request sert à surveiller la liaison dans un sens

seulement (hôte local vers hôte distant).

Dans ces trois paquets, la zone de données contient un champ Magic

Number, option LCP négociable, qui sert à

détecter les cycles dans les liaisons de données.

Les options

de configuration de LCP

Les options de configurations LCP identifient les caractéristiques

négociables de la liaison point à point. Chaque

option a une valeur par défaut.

PPP utilise la valeur par défaut quand un paquet Configure-Request

n’inclut pas d’option durant la phase

d’établissement de liaison.

Dans une trame Configure-Request , on peut envoyer plusieurs options à

négocier avec le site distant. Les options

n’étant pas incluses dans cette trame, ne sont pas négociées

et leurs valeurs par défaut leur sont affectées.

Format général

d’une option

Le champ Longueur indique la taille totale de l’option de configuration.

Les champs Type, Longueur et Data étant inclus.

Le format et le contenu du champ Data sont spécifique à chaque

option de configuration.

Le champ Type identifie le type de l’option de configuration à négocier.

Les différentes valeurs de ce champ sont :

0 - Réservé

1 - Maximum Receive Unit

3 - authentication Protocol

4 - Quality Protocol

5 - Magic Number

7 - Protocol Field Compression

8 - Adress and Contrtol Field Compression

Maximum

Receive Unit (MRU)

Cette option permet de négocier la taille maximum d’un paquet.

Sa valeur par défaut est de 1500 octets.

Les sites distants peuvent négocier des tailles plus grandes ou plus

petites que la taille par défaut. Il n’est pas

nécessaire que les serveurs ajoutent des octets de bourrages pour

atteindre la valeur du MRU, ils peuvent toujours

envoyer des paquets de longueur inférieure.

Le champ Longueur a toujours pour valeur 4.

Le champ MRU indique le nombre maximum d’octet du champ Information de la

trame PPP. La taille du MRU

n’inclut donc pas les autres champs de la trame PPP.

Authentication

Protocol

Les clients peuvent utiliser cette option pour négocier l’utilisation

d’un protocole d’authentification particulier,

car certains réseaux incluent des protocoles d’authentification au

niveau réseau.

Par défaut, celle-ci n’est pas nécessaire. Quand un hôte

émet un paquet Configure-Request avec l’option

Authentication Protocol, il veut que le récepteur "s'authentifie".

Quand le récepteur envoie la réponse

Configure-Ack avec l'option Authentication Protocol, il accepte l'authentification,

en utilisant le protocole

d'authentification spécifié.

Ces hôtes peuvent ne pas utiliser les mêmes protocoles d'authentification

dans les deux sens. Ils peuvent

négocier l'utilisation de protocoles différents pour chaque

sens.

Le format de cette option est similaire a l'option précédente.

A la place du champ MRU, cette option inclut

les champs Authentication Protocol, et Data qui peut contenir des informations

supplémentaires sur le

protocole d’authentification demandé.

Quality

Protocol

PPP fournit la possibilité de contrôler la qualité

de la liaison. Cette option permet aux hôtes de négocier

l'utilisation d'un protocole spécifique qui sert à contrôler

la quantité de données perdues sur la liaison.

De même que pour l'option précédente, les hôtes

peuvent négocier l'utilisation de différents protocoles

de qualité dans chaque sens. L'option inclut aussi un champ Data qui

peut contenir des informations

supplémentaires sur le protocole de qualité demandé.

Magic Number

Elle est utilisée pour détecter les éventuelles anomalies

sur la liaison de données et les cycles de rebouclage.

Par défaut, cette option n'est pas négociée. A la place,

un 0 est inséré dans le champ Magic Number.

Quand un hôte reçoit un paquet Configure-Request avec l'option

Magic Number, il le compare au Magic Number

du dernier paquet Configure-Request. Si les deux nombres diffèrent,

il n'y a pas de rebouclage. Sinon il est

possible qu'il y ait un rebouclage : l'hôte reçoit ses propres

transmissions. Donc, pour lever le doute, un paquet

Configure-Nak doit être envoyé indiquant qu'il faut un autre

Magic Number.

Si le Magic Number du Configure-Nak est différent de celui envoyé

dans le dernier Configure-Nak, il n'y a pas

de cycle, et ce nombre est bien unique. Sinon il y a bien bouclage, et un

nouveau Magic Number doit être déterminé.

Toutes les mises en oeuvre de PPP peuvent détecter les cycles.

Cependant, le procédé que chaque application

utilise pour y remédier est spécifique à chacune.

Protocol

Field Compression

Dans certains cas, les deux octets du champ Protocol peuvent être

compressés et réduits à un octet. Cette

option permet aux hôtes de négocier la compression du champ

Protocol de la trame PPP.

Quand un hôte envoie un paquet Configure-Request avec l'option Protocol

Field Compression et reçoit un

paquet Configure-Ack en réponse, les deux hôtes peuvent utiliser

un octet pour le champ Protocol.

Dans tous les cas, les applications PPP doivent toujours accepter le champ

Protocol avec deux octets, même

si l'option a été négociée. Le FCS est alors

calculé sur la trame compressée.

Address

and Control Field Compression.

Puisque dans une trame PPP, les champs Address et Control ont des valeurs

constantes, ils peuvent être

compressés. Cette option permet à un hôte de négocier

la compression de ces deux champs.

Le FCS est alors calculé sur la trame compressée.

Les protocoles de controle réseau (NCPs)

Les protocoles de contrôle réseau (NCPs - Network Control

Protocols) sont des protocoles séparés qui

fournissent les informations de configuration et de contrôle destinées

aux protocoles de la couche réseau.

PPP est conçu pour transmettre des données pour une multitude

de protocoles réseau. NCP autorise la

personnalisation de PPP de manière à exécuter uniquement

cette tache. Chaque protocole de réseau

(DECnet, IP, OSI, etc. ...) possède son propre protocole NCP.

IPCP - Description

Le protocole de contrôle pour le protocole Internet (IPCP - IP Control

Protocol ) se charge de configurer,

d’autoriser ou non l’utilisation de datagramme IP (Internet Protocol ) sur

la liaison point à point .

Semblable au protocole LCP, cette phase s’effectue en échangeant des

paquets. Les paquets IPCP

ne seront échangés seulement si le protocole LCP autorise la

phase de négociation de configuration

de la couche réseau. De même, les datagrammes IP ne seront pas

échangés tant que IPCP n’accepte

pas la connexion.

Fonctionnement

de IPCP

Le protocole IPCP est très semblable au protocole LCP, à

quelques exceptions près :

- Le Paquet IP est encapsulé dans le champ Information de la trame

de couche de liaison de donnée ou le

champ protocole a la valeur hexadécimale 8021.

- Le champ Code utilise seulement un code parmi les sept disponible ( Configure-Request,

Configure-Ack,

Configure-Nak, Configure-Reject, Terminate-Request, Terminate-Ack et Code-Reject).

Les autres codes

sont traités comme des paquets inconnus et sont retournés au

site distant - Paquet Code-Reject.

La longueur maximum d'un paquet IP transmis sur une liaison PPP est la même

que la longueur

maximum du champ Information de la trame PPP. Les datagrammes de longueur

plus importante

devront être fragmentés. Le rassemblement des datagrammes devra

être assuré par la couche

transport du système. Il est possible de limiter la longueur de la

trame IP à l'aide l'option Maximum

Segment Size de la couche TCP, Cette option favorisera la transmission puisque

le rassemblement

des paquets n'est plus nécessaire.

Les adresses

IP

Une option de configuration permet de négocier l'adressage IP de

chaque site. Par défaut aucune

adresse n'est assignée. Une adresse désignée par la

valeur zéro peut être négociée comme une

requête du site distant pour que celui-ci spécifie son adresse

IP.

Type de

compression

Cette option fournit un moyen de négocier le protocole de compression

des paquets IP. Par défaut,

cette option n'est pas activée.

Le champ Type de compression contient une valeur correspondant à

l'algorithme de compression à utiliser.

Pour la compression des entêtes TCP/IP de Van-Jacobson cette valeur

correspond à 0037 en hexadécimal.

Informations

complémentaires sur NCP

PAP -Password Authentication Protocol

Le protocole d'authentification par mot de passe (PAP) est une méthode

simple pour établir l'identité du site

distant. Elle est semblable à la procédure login d'une session

sur un serveur. Ceci est effectué seulement

après que la liaison a été établie.

Après que le protocole LCP, a accepté la liaison au site distant.

Le client s'authentifie auprès du serveur

en lui envoyant un paquet Authentication-Request contenant l'identité

du client et le mot de passe associé.

Le serveur compare ces données à celle contenu dans son fichier

d'authentification.

L'inconvénient de cette technique est que le mot de passe transit

"en clair" sur la liaison.

Exemple de fichier sur un site de type UNIX :

# /etc/ppp/pap-secrets

#

# User Server Secret Adresse

Vlager-pap c3po cresspahl vlager.vbrev.com

c3po vlager DonaldGNU c3po.lucas.com

Les deux premiers champs contiennent toujours l'adresse de l'utilisateur

et du serveur associé. Le troisième

champ correspond au secret - Mot de passe - associe de façon unique

à un utilisateur ou à un groupe

d'utilisateur. La première ligne est utilisée pour authentifier

le serveur contenant ce fichier auprès du serveur

c3po. La seconde ligne décrit comment un utilisateur distant nomme

c3po sera authentifié avec ce serveur.

Le quatrième est optionnelle, il contient l'adresse IP du client.

Sur un autre environnement, ce fichier n'a pas obligatoirement le même

format.

CHAP - Challenge-Handshake Authentification Protocole

Si on veut éviter l'envoi de paquets contenant le mot de passe

sur la liaison point à point, l'utilisation du

protocole d'authentification CHAP est plus que recommandée. Celui-ci

permet ainsi d'accroître la sécurité du site.

Avec ce protocole le serveur envoi au client un paquet contenant un challenge

- mot de 16 bits définit

aléatoirement - et son nom. Le client récupère dans

sa table définit localement, à l'aide du nom du serveur,

le secret correspondant. Le client combine le secret approprié avec

le challenge, crypte ce résultat. Le

résultat du cryptage est retourné au serveur avec le nom du

client. Le serveur effectue les même opérations.

Si les deux résultats sont identiques la connexion du client est acceptée.

Exemple de fichier sur un site de type UNIX :

Le format de fichier contenant les mots de passe pour le protocole CHAP est

semblable a pap-secret vu ci-dessus.

# /etc/ppp/chap-secrets

#

# Client Server Secret Adresse

Vlager-pap c3po.lucas.com cresspahl vlager.vbrev.com

c3po vlager.vbrew.com DonaldGNU c3po.lucas.com

CHAP permet d'effectuer l'authentification a n'importe quel moment durant

la liaison afin d'être sur que

le client n'a pas était remplacé par un intrus.

L'implémentation des algorithmes de cryptage doit bien sur être

identique sur les deux serveurs distants.

Il est possible a l'aide des options de configuration de LCP de choisir des

algorithmes spécifiques

paquet - Authentication Protocol.

Remarque: Les datagrammes transmis après la procédure d'authentification

ne sont pas cryptés. Il est

donc possible par écoute de la ligne de voir ces données. La

sécurité n'est donc, sur une liaison

point à point, pas totale.

Si on désire crypter les données à transmettre, le cryptage

s'effectue au niveau des datagrammes et doit

être assurer par la couche réseau.

L'authentification du site distant

Par soucis de sécurité, afin de permettre un accès

privilégié à des données " sensibles" ou à

des services

payants, il est nécessaire de connaître l'identité du

site distant.

Le protocole PPP contient deux protocoles d’authentification, PAP et CHAP,

qui sont négociés à l’aide du

protocole de couche liaison LCP. L’authentification auprès d’un site

est, bien sûr, optionnelle.

L'authentification est effectuée, après que LCP a terminé

la configuration des options. En cas d'échec

- l'identité du site distant non reconnue - la connexion est tout

simplement interrompue.

L'authentification est demandée, soit par le demandeur de connexion

(client), soit par l'offreur de connexion

(serveur).

Remarque sur PPP

PPP s'avère un protocole nettement plus puissant que SLIP. Les

options de configurations étant nombreuses,

sa mise en œuvre est plus délicate ; Il est moins souvent utilisé.

Cependant les avantages résultant de l'utilisation

de PPP en font le protocole de ligne série de l'avenir et le choix

probable des distributeurs de routeurs à la recherche

d'un mécanisme standard de transmission sur des lignes série.

Conclusion : SLIP ou PPP ?

Nombre d'administrateurs réseau débattent du choix du meilleur

protocole série. En réalité, l'utilisation du

"meilleur protocole" ne constitue pas toujours le choix correct ; il s'agirait

plutôt de sélectionner le

"protocole approprié" à une situation particulière.

PPP constitue un meilleur choix puisqu'il permet le transport de datagrammes

de nombreux protocoles de

couche réseau. Par conséquent, il assure l'interopérabilité

entre les systèmes commercialisés par une large

palette de distributeurs. De plus, PPP possède plus d'options et est

plus puissant que le protocole SLIP. Compte

tenu de ces éléments PPP constitue le choix approprié

comme protocole non-propriétaire pour assurer la connexion

des routeurs sur les lignes série. Etant donné que SLIP a été

le premier protocole série IP largement répandu, il est

par conséquent disponible pour un plus grand nombre de types de matériel

que PPP.

L'accès commuté constitue l'une des applications les plus utilisées

pour IP sur les lignes série. Le protocole SLIP

est plus souvent utilisé à cette fin que le protocole PPP,

puisque nombre de système qui proposent l'accès commuté

supportent uniquement SLIP. SLIP est disponible pour la plupart des serveurs

et dans majorité des mises en œuvre

PC de TCP/IP.

SLIP et PPP ne peuvent échanger des informations, il s'agit de protocole

complètement différent. Dés lors, si vos

serveurs utilisent uniquement SLIP, les hôtes à distance,

interconnectés au travers de ces serveurs doivent

aussi utiliser SLIP. Etant donné le nombre de protocoles SLIP, celui-ci

sera encore présent de nombreuses années.

SLIP et PPP tombent aujourd'hui en désuétude remplacés

par des protocoles offrant une meilleure garantie de

sécurité, la plupart basé sur PPP (PPTP, L2F, L2TP...)

Les Principaux protocoles de VPN

PPTP (Point to Point Tunnelling Protocol)

Introduction

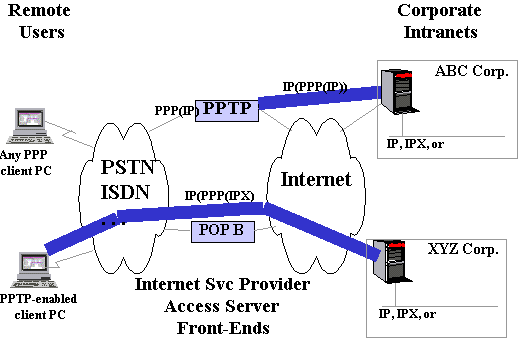

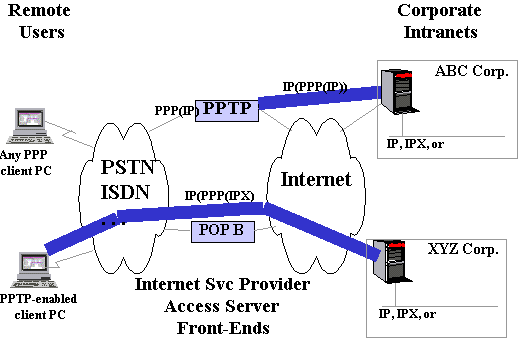

Le protocole Point-to-Point Tunneling (PPTP) est un protocole qui permet

aux connexions

Point-to-Point Protocol (PPP) d'être convoyées au travers d'un

réseau IP en créant un réseau virtuel privé (VPN).

Microsoft a implémenté ses propres algorithmes et protocoles

afin d'intégrer PPTP. Cette implémentation de PPTP,

appelée Microsoft PPTP, est largement utilisée dans des produits

VPN commerciaux en particulier parce que le PPTP

fait déjà partie des systèmes d'exploitation Windows

95, 98 et NT.

Le protocole Point-to-Point Tunneling (PPTP) est utilisé pour protéger

les connexions PPP au-travers

de liaisons TCP/IP. Microsoft a distribué des extensions au

mécanisme d'authentification PPTP (MS-CHAP),

appellées MS-CHAPv2. Nous présentons une vue d'ensemble des

modifications apportées aux portions

d'authentification et de génération des clefs de chiffrement

de MS-CHAPv2, et évaluons les améliorations

et les faiblesses qui persistent dans l'implémentation PPTP de Microsoft.

Le protocole d'authentification dans Microsoft PPTP est le protocole d'épreuve/réponse

de Microsoft (MS-CHAP) ;

le protocole de chiffrement est le chiffrement Point to Point de Microsoft

(MPPE). Après la cryptanalyse de

Microsoft PPTP et la révélation publique de ses faiblesses

importantes, Microsoft a mis à jour ses protocoles.

La nouvelle version s'appelle MS-CHAP version 2 (MS-CHAPv2); l'ancienne version

a été renommée MS-CHAP

version 1 (MS-CHAPv1). MS-CHAPv2 est disponible sous la forme d'une mise

à jour pour Microsoft Windows 95,

Windows 98 et Windows NT 4.0 (DUN 1.3). Bien que cette mise à jour

soit disponible, nous pensons que

la plupart des implémentations utilisent MS-CHAPv1.

Le protocole de tunneling le plus utilisé est le protocole PPTP (Point

To Point Tunneling Protocol ). Le principe

de ce protocole est de créer des paquets sous le protocole PPP et

de les encapsuler dans un datagramme IP.

Ainsi, dans ce mode de connexion, les machines distantes des deux réseaux

locaux sont connectées par une

connexion point à point (comprenant un système de cryptage

et d'authentification, et le paquet transite au sein

d'un datagramme IP.

De cette façon les données du réseau local (ainsi que

les adresses des machines présentes dans le l'en-tête

du message) sont encapsulées dans un message PPP, qui est lui-même

encapsulé dans un message IP..

C’est un protocole de niveau 2 qui encapsule des trames PPP dans des datagrammes

IP afin de les transférer

sur un réseau IP. PPTP permet le cryptage des données PPP encapsulées

mais aussi leur compression.

Le schéma suivant montre comment un paquet PPTP est assemblé

avant d’être transmis par un client distant

vers un réseau cible.

L’intérêt de PPTP est de ne nécessiter aucun matériel

supplémentaire car les deux logiciels d’extrémité

(le client et le serveur) sont intégrés dans NT4. Par contre,

il ne fonctionne que sous NT pour le moment.

Le protocole d'authentification dans Microsoft PPTP est le protocole d'épreuve/réponse

de Microsoft (MS-CHAP)

et le protocole de chiffrement est le chiffrement Point to Point de Microsoft

(MPPE). Après la cryptanalyse de

Microsoft PPTP et la révélation publique de ses faiblesses

importantes, Microsoft a mis à jour ses protocoles.

La nouvelle version s'appelle MS-CHAP version 2 (MS-CHAPv2); l'ancienne version

a été renommée MS-CHAP

version 1 (voir annexe).

Cryptanalyse des extensions d'authentification PPTP de Microsoft

(MS-CHAPv2)

Ce document examine MS-CHAPv2 et discute comment

il règle les failles de sécurité.

Les changements les plus importants de MS-CHAPv1 vers MS-CHAPv2 sont:

Le hachage faible LAN Manager n'est plus transmis en même temps que

le hachage Windows NT plus fort. Ceci

afin d'éviter que des casseurs automatiques de mots de passe, comme

L0phtcrack (http://www.l0pht.com/l0phtcrack)

ne cassent le premier hachage et d'utiliser l'information obtenue pour casser

le hachage plus fort Windows NT.

Un système d'authentification pour le serveur a été

introduit, afin d'empêcher des serveurs malicieux de se faire passer

pour des utilisateurs légitimes.

Les paquets d'échange de mots de passe de MS-CHAPv1 ont été

remplacés par un unique paquet d'échange dans

MS-CHAPv2. Ceci afin d'empêcher l'attaque active de détournement

( spoofing ) des paquets d'échec de MS-CHAP.

MPPE utilise des clefs uniques dans chaque direction, afin d'empêcher

l'attaque cryptanalytique triviale du XOR de

chaque flux dans chaque direction qui supprime les effets du chiffrement.

Ces changements corrigent les faiblesses majeures de sécurité

du protocole originel: l'inclusion d'une fonction de

hachage LAN Manager et l'utilisation de la même clef de chiffrement

OFB à plusieurs reprises. Toutefois, beaucoup

de problèmes de sécurité restent sans correction, par

exemple comment le client se protège lui-même ou le fait que

la clef de chiffrement dispose de la même entropie que le mot de passe

de l'utilisateur et le fait qu'assez de données

soient transmises sur la ligne et permettent à des attaquants de réaliser

des attaques de chiffrement et comparaison.

Ceci dit, Microsoft n'a visiblement pas seulement profité de cette

opportunité que pour corriger quelques faiblesses

cryptographiques dans leur implémentation de PPTP, mais aussi pour

améliorer la qualité de leur code. La nouvelle

version est beaucoup plus robuste contre les attaques de dénégation

de service et ne laisse plus filtrer d'information

au sujet du nombre de sessions VPN actives.

MS-CHAP, Versions 1 et 2

En résumé:

Le client fait une demande d'épreuve au serveur.

Le serveur envoie une épreuve avec 8 octets aléatoires.

Le client utilise le hachage LAN Manager de son mot de passe pour en dériver

trois clés DES. Chacune de ces clés

est utilisée pour chiffrer l'épreuve. Les trois blocs sont

concaténés dans une réponse de 24 octets. Le client

crée alors

une seconde réponse de 24 octets en utilisant le hachage Windows

NT, avec la même procédure.

Le serveur utilise les hachages du mot de passe client, conservés

dans une base de données, afin de déchiffrer ses

réponses. Si les blocs une fois déchiffrés correspondent

à l'épreuve, alors l'authentification est complète et

un paquet

de "succes" est transmis au client.

Cet échange a été modifié dans MS-CHAPv2. Le

protocole révisé est le suivant:

1. Le client demande une épreuve au serveur.

2. Le serveur envoie en réponse une épreuve

de 16 octets aléatoires.

3.

a. Le client génère un nombre aléatoire

de 16 octets, appelé "l'épreuve égale d'authentification."

b. Le client génère une épreuve de

8 octets en hachant l'épreuve de 16 octets reçue à l'étape

(2), les 16 octets de

l'épreuve égale d'authentification générée

à l'étape (3a) et le nom de l'utilisateur du client. (Voir

la section 3 pour les

détails).

c. Le client crée une réponse de 24 octets,

en utilisant la fonction de hachage Windows NT et les 8 octets de l'épreuve

générés à l'étape (3b). Ce processus est

identique à celui de MS-CHAPv1.

d. Le client transmet au serveur les résultats des

étapes (3a) et (3c).

4.

a. Le serveur utilise les hachages du mot de passe du client,

conservé dans une base de données, afin de déchiffrer

les

réponses. Si les blocs déchiffrés correspondent à

l'épreuve, le client est authentifié.

b. Le serveur utilise les 16 octets de l'épreuve

égale d'authentification du client, tout comme le mot de passe haché

du

client, afin de créer une "réponse d'authentification" de 20

octets (voir la section 4 pour les détails).

5. Le client calcule aussi une réponse d'authentification.

Si celle-ci correspond à celle reçue en réponse, le

serveur est

authentifié.

Une description générale des changements entre MS-CHAPv1

et MS-CHAPv2 est donnée en figure 1.

|

MS-CHAP version 1 |

MS-CHAP version 2 |

| Négociation CHAP

avec une valeur d'algorithme de 0x80. |

Négociation CHAP

avec une valeur d'algorithme de 0x81. |

| Le serveur envoie une

valeur épreuve de 8 octets. |

Le serveur envoie une

valeur de 16 octets qui devra être utilisée par le client

dans la création d'une valeur d'épreuve de 8 octets. |

| Le client envoie 24 octets

LANMAN et 24 octets NT en réponse aux 8 octets d'épreuve. |

Le client envoie 16 octets

d'épreuve égale qui ont été utilisés

pour créer l'épreuve de 8 octets cachés, et

la réponse NT en 24 octets. |

| Le serveur envoie une

réponse indiquant le SUCCES ou l'ECHEC. |

Le serveur envoie une

réponse indiquant SUCCES ou ECHEC et transmet une réponse

d'authentification de 16 octets. |

| Le client décide

de continuer en fonction de la réponse SUCCES ou ECHEC du serveur. |

Le client décide

de continuer en fonction de la réponse SUCCES ou ECHEC. En

plus, le client vérifie la validité de la réponse

d'authentification et se déconnecte si elle est incorrecte. |

Figure 1: quelques différences de base entre les authentifications

MSCHAP v1 et MSCHAP v2

Ce protocole fonctionne, et élimine la faiblesse la plus importante

qui frappait MS-CHAPv1. Dans MS-CHAPv1, deux

valeurs parallèles de hachage étaient transmises par le client

au serveur: le hachage LAN Manager et le hachage

Windows NT. Il s'agissait de deux hachages différents d'un même

mot de passe. Le hachage LAN Manager est

beaucoup plus faible que celui de Windows NT, et un programme à briser

les mots de passe comme L0phtcrack

était capable de briser le hachage LAN Manager et d'utiliser cette

information pour briser le hachage Windows NT.

En éliminant le hachage LAN Manager dans MS-CHAPv2, Microsoft a rendu

cette attaque de conquête par la division

impossible. Malgré cela, la sécurité de ce protocole

reste basée sur le mot de passe utilisé, et L0phtcrack peut

toujours casser les mots de passe faibles par une attaque à dictionnaire.

Comme nous en discuterons plus loin, des couches multiples de hachage sont

utilisées à différentes étapes de

MS-CHAPv2. Bien que ce hachage soit utilisé pour dissimuler certaines

valeurs, leur signification cryptographique

n'est pas claire. Elles semblent n'avoir pour effet qu'une réduction

de la vitesse d'exécution du protocole.

Nous avons aussi des inquiétudes quant à la quantité

de contrôle dont dispose le client sur l'influence portant sur

les 8 octets d'épreuve utilisés, bien que nous n'ayons pas

encore conçu une attaque viable capable de l'exploiter.

Cela ouvre certainement une attaque par canal subliminal, qui peut être

exploitée dans d'autres contextes.

MS-CHAPv2: dériver

l'épreuve 8 octets à partir de la réponse

24 octets

Dans MS-CHAPv1, le serveur envoie au client une épreuve

aléatoire de 8 octets. Cette épreuve est utilisée avec

le

mot de passe du client et une fonction de hachage afin de créer

une paire de réponses à 24 octets.

Dans MS-CHAPv2, le serveur envoie au client une épreuve de 16 octets.

Cette épreuve n'est pas utilisée directement

par le client; il en dérive une valeur de 8 octets. Ce processus de

dérivation est le suivant:

Le client crée un nombre aléatoire de 16 octets, appelé

l'épreuve égale d'authentification.

Le client concatène l'épreuve égale d'authentification

avec l'épreuve de 16 octets reçue du serveur et le nom d'utilisateur

du client.

Le client hache le résultat avec SHA-1.

Les premiers huit octets du hachage deviennent l'épreuve 8 octets.

Ce sont ces 8 octets que le client va utiliser pour chiffrer le hachage local

du mot de passe 16 octets (en utilisant la

fonction de hachage Windows NT) afin d'obtenir une réponse 24 octets,

que le client va transmettre au serveur. Cette

méthode est identique à MS-CHAPv1.

Analyse

Les raisons qui ont poussé à rendre ce

protocole aussi compliqué ne nous semblent pas claires. Au premier

regard, il

semble raisonnable que le client n'utilise pas l'épreuve du serveur